AI訓練數據即將耗盡?2026年或面臨數據荒,過度訓練成罪魁禍首

人工智能發展迅速,大模型訓練所需數據問題日益凸顯。一方面,數據短缺的風險日益增加;另一方面,這些數據對于提升模型性能至關重要。這種矛盾現象已成為當前AI領域的一大問題。

大模型訓練數據的現狀

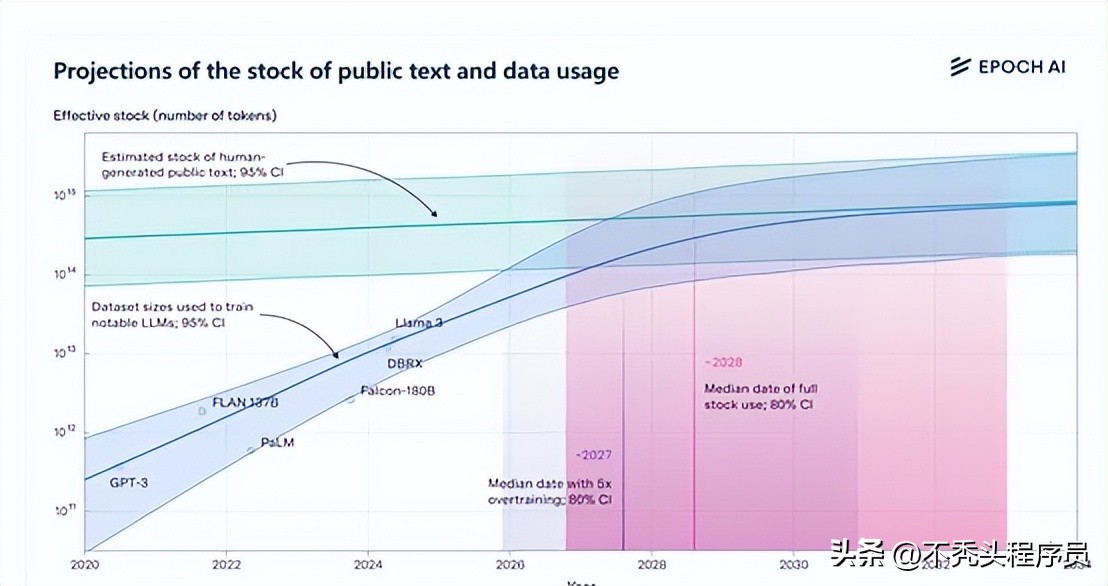

目前,人類公開的高質量文本訓練數據集規模已達到約300萬億個tokens。以Meta開源的Llama 3的8B版本為例,它的過度訓練量可以達到原始的100倍。這一情況揭示了當前大模型訓練數據量極為龐大的現實。同時,在大模型領域,數據的重要性已經和AI算力相當,對模型性能有著決定性的影響。許多企業已經認識到了這一點,紛紛加大在數據領域的投入和研究力度。

在現有數據狀況下,過擬合問題同樣不可忽視。當模型結構過于繁復,或是訓練時間過長時,過擬合現象便會顯現。此時,模型會專注于記憶數據中的噪聲,而非對新數據做出有效推廣。這種情況在實際應用中可能引發風險,因此我們需采取相應措施來加以防范。

過度訓練的正負影響

在深度學習領域,尤其是在訓練大型模型時,人們常常故意讓模型過度訓練。這種做法有利有弊,好處之一是可以減少推理所需的時間和提升處理速度。采用這種策略,模型能更好地識別出訓練數據中的噪聲和具體信息,而不僅僅是掌握數據的一般規律。

然而,這同時也引發了一些問題。若開發者將比例提升至超出理想范圍,訓練階段對數據的需求便會上升。若持續使用此訓練方法,有預測指出,數據可能在2025年面臨枯竭。這對整個行業而言,既構成了巨大挑戰,也潛藏了風險。

合成數據的優劣

深度學習常用來復制現實數據,以此來制造新的數據。當數據不夠用的時候,這種方法特別重要,因為它能大大增加數據量。但這種方法也有它的缺點。制造出來的數據可能不夠好,還容易導致過度擬合的問題。

合成數據難以充分展現真實數據的復雜與多樣。這可能是因為它未能準確捕捉到真實文本中的細微語言特征,或者是因為過度依賴單一數據集,結果使得文本的多樣性不夠。盡管存在這些不足,合成數據依然是多模態大模型訓練的重要方式之一。

數據搜集相關努力

科技公司正致力于在數據領域尋求突破。以OpenAI為例,它設立了數據合作組織,目的是搜集高質量的個人數據,用于GPT系列模型的訓練。此外,迫切需要研發新的技術手段和方法,確保能高效地收集、整理和規范這些個人數據,使其滿足訓練標準。這一過程無疑充滿挑戰,需要攻克眾多技術難題。

同時,我們得重視數據的合規與保密,尤其是那些未對外公布的個人資料。若處理不善,可能會觸發侵犯用戶隱私等權利的隱患,從而對公司形象和信譽帶來嚴重傷害。

與現實世界互動學習的意義

大模型與真實世界的互動學習方式很有價值。它與以往僅依賴固定數據集的訓練方法有區別。在這種方式中,大模型不僅能被動接受數據,還能主動探索周圍環境,并與人類交流,來獲取知識和技能。

在推薦餐廳時,大模型需深入了解用戶偏好,同時能即時收集并分析相關餐廳信息。而且,這種模型還需具備處理不確定性的能力,這與傳統模式有較大差異,也是其獨特之處。

訓練數據競爭的未來走向

目前,閉源或開源的大規模模型正面臨數據量的較量。采用RAG、MoE、MTL等創新技術,即便是參數較少的模型,只要其學習的數據量更充足、覆蓋的領域更廣泛,就有可能超越參數量較多的模型。

未來,競爭將愈發劇烈。開發者必須保證數據充足,同時避免數據資源耗盡。他們還需尋找新的數據渠道,例如合成數據,并努力克服這些數據可能帶來的負面影響。這些問題,當前迫切需要解決。

知道了大模型訓練所需數據的詳情,大家覺得哪個行業最有可能解決訓練數據面臨的各種挑戰?期待大家在評論區積極討論,也歡迎大家點贊和分享這篇文章。

作者:小藍

鏈接:http://www.huanchou.cn/content/6978.html

本站部分內容和圖片來源網絡,不代表本站觀點,如有侵權,可聯系我方刪除。